Unos astrónomos han podido medir el efecto de la energía oscura sobre algunos de los objetos del Universo más masivos conocidos gracias al telescopio de rayos X Chandra. Hasta el momento es la mejor prueba disponible sobre la existencia de esta energía oscura y de su semejanza con la constante cosmológica de Einstein.

|

| Uno de los cúmulos observados, que brilla en rayos X debido al gas caliente que contiene. Foto: NASA, CXC, SAO. | |

El resultado, que aparecerá publicado el 10 de febrero de 2009 en Astrophysical Journal, se basa en cómo la energía oscura ha contenido el crecimiento de cúmulos de galaxias y en la utilización de estudios previos. Han obtenido la mejor pista hasta el momento sobre la naturaleza de la energía oscura y sobre el destino final del Universo. Es un método independiente de los hasta ahora usados para el estudio de la energía oscura, y centrados generalmente en la observación de explosiones de supernovas lejanas. Para realizar este trabajo necesitaron varios años de trabajo.

La naturaleza de la energía oscura es uno de los grandes misterios de la ciencia actual desde que se descubrió hace una década. El sentido común dictamina que el Universo debería de expandirse cada vez más lentamente según la gravedad frenara dicha expansión. Pero lo que observaron fue todo lo contrario: la expansión se estaba acelerando. Entre las posibles soluciones que se han aportado para solucionar este problema está la existencia de una constante cosmológica, modificaciones de la ley de la gravedad, existencia de huecos cósmicos, etc. La energía oscura sería una suerte de repulsión gravitatoria y bajo nuestro punto vista lo que parece es que la expansión cósmica se está acelerando siendo cada vez más rápida.

En todo caso el efecto de la energía oscura es que se opone a la gravedad (que depende de la masa de los objetos), compitiendo con ella, y por tanto debe de tener una influencia mensurable en objetos grandes y masivos como las estructuras cosmológicas. El estudio de este tipo de estructuras es más preciso que el método tradicional de observar explosiones de supernova de tipo Ia.

La energía oscura trabajaría en contra de la acumulación de masa (de galaxias) por parte de los cúmulos. Lo que sea que esté acelerando la expansión del Universo ahora está forzando a que se “desarrolle” lentamente, según los autores del estudio.

Se cree que en el pasado la energía oscura no era dominante y la fuerza dominante era la gravedad. Para los observadores de esa época se producía una desaceleración en la velocidad de expansión del Universo, situación que hace entre 5000 y 10.000 millones de años se invirtió. Si la tendencia sigue el Universo se expandirá cada vez más rápido hasta que esté prácticamente vacío de objetos.

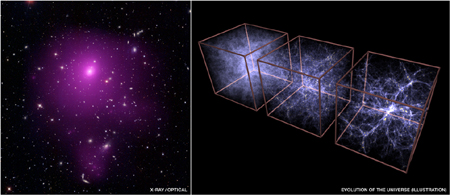

Si se observan cúmulos de galaxias a distintas distancias se pueden observar cómo crecían los cúmulos en distintas épocas del pasado y ver cómo les afectaba la energía oscura en su momento.

Alexey Vikhlinin del Smithsonian Astrophysical Observatory en Cambridge y sus colaboradores observaron docenas de cúmulos de galaxias que se cuentan entre los objetos masivos más grandes del Universo. Los cúmulos de galaxias observados están rellenos de gas muy caliente, gas que emite por tanto rayos X y que el telescopio Chandra puede detectar.

Algunos de esos cúmulos están relativamente cerca y otros a mitad de distancia del borde del Universo visible. De los 86 cúmulos observados 37 estaban a unos 5000 millones de años luz de distancia (y por tanto los vemos como eran hace 5000 millones de años) y 49 a unos 500 millones de años luz. Sus masas fueron determinadas mediante las imágenes de rayos X y sus espectros dando una gama de masas que iban de 1012 a 18 masa solares.

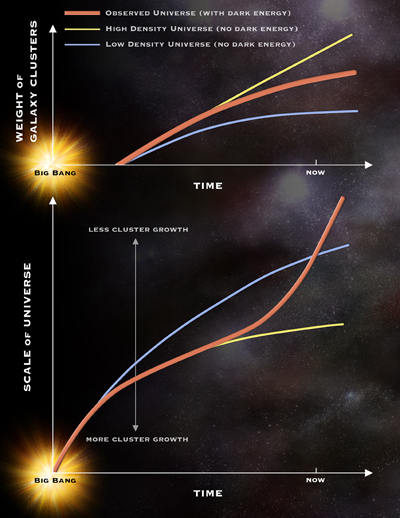

Lo resultados indican que los cúmulos más masivos son sólo un cincuentavo a día de hoy de lo que serían si no hubiera energía oscura. Los cúmulos siguen creciendo actualmente, pero muy lentamente.

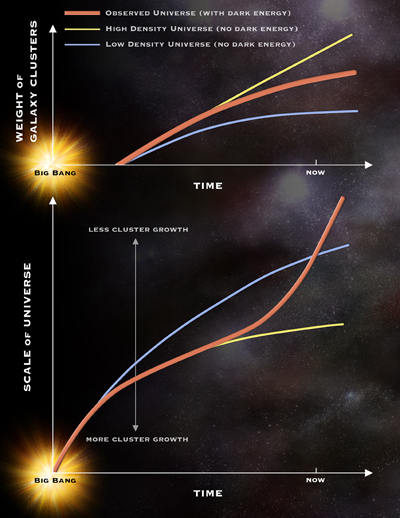

Los resultados muestran que el aumento de masa de los cúmulos de galaxias en el tiempo se ajusta a un Universo dominado por la energía oscura. A los cúmulos les es más difícil crecer (acumular galaxias y por tanto masa) si el espacio crece más rápidamente debido a la energía oscura. Según los datos de estos investigadores el resultado está claro y es fuertemente consistente a grandes distancias.

Redondeando las cifras los cúmulos crecieron rápidamente durante los primeros 10.000 millones de años y después no han crecido o lo han hecho más lentamente en los últimos 5.000 millones de años.

|

| Estos dibujos ilustran el peso de un cúmulo de galaxias típico y los cambios en las escala del Universo a lo largo del tiempo cósmico. La línea naranja corresponde al Universo observado con energía oscura y aceleración cósmica. Las líneas amarilla y azul corresponden a modelos de alta y baja densidad y sin energía oscura. Los resultados sobre los datos en los últimos 7000 millones de años de nuestro Universo concuerdan muy bien con un Universo dominado por la energía oscura. Foto: NASA, CXC, M.Weiss. | |

Cuando estos resultados se combinan con otros como los procedentes de explosiones de supernovas o los del fondo cósmico de microondas los científicos pueden obtener una mejor comprensión de esta misteriosa energía. La explicación que mejor se ajusta a la energía oscura sería la de la constante cosmológica. La constante cosmológica, un concepto introducido por Einstein en la RG, es constante para una unidad de espacio dada, es una energía del vacío, pero como con el tiempo se va creando más espacio debido a la expansión el efecto de repulsión crece cada día más, el espacio se expande más y así sucesivamente. Lo que observamos finalmente es una aceleración de la expansión cosmológica. Ahora la energía oscura constituye un 72% de la energía total del Universo, pero fue inferior en el pasado.

Sin embargo, aunque la constante cosmológica, se puede meter de manera natural en la Relatividad General, no es fácil hacerla aparecer en análisis teóricos mecanicocuánticos. Las teorías cuánticas de campos predicen una energía del vacío 120 órdenes de magnitud por encima de lo observado (algo que impediría la formación de cualquier estructura en el Universo) y las teorías de cuerdas (unas teorías cada vez más “fraudulentas”) ni siquiera pueden predecirla.

Como métodos diferentes han dado resultados iguales los expertos dicen que es la mejor prueba a la que se ha sometido la Relatividad General y un fracaso para las teorías MOG alternativas que intentan modificarla. Otros se resisten a creer que la partida ha terminado y dicen que todavía hay margen para las sorpresas. Mientras, algunos astrofísicos temen que las medidas nunca serán lo suficientemente precisas como para demostrar o refutar la existencia de la constante cosmológica.

Por otro lado J. P. Zibin, Adam Moss, y Douglas Scott de University of British Columbia también publican en Physical Review Letters un artículo sobre este tema. En él mantienen que basándose en datos procedentes del fondo cósmico de microondas no es posible explicar la energía oscura como un espejismo producido por una situación privilegiada de nuestra galaxia en un hueco cósmico.

Si finalmente la energía oscura es una constante cosmológica el destino del Universo será seguir acelerándose con una velocidad de expansión que crecerá con el tiempo. Los objetos irán desapareciendo de nuestro horizonte observacional en una especie de “agujero negro invertido” conforme sus corrimientos al rojo se hagan infinitos incluyendo el fondo cósmico de microondas. Dentro de 100.000 millones de años la Vía láctea, la galaxia de Andrómeda y el Cúmulo De Virgo habrán formado un único supercúmulo estelar en el Universo visible. Un cúmulo suspendido en el espacio vacío y similar al modelo de De Sitter. Conforme lleguemos a ese punto la información que nos permitió saber sobre la existencia del Big Bang habrá desaparecido para siempre, produciéndose una suerte de olvido cósmico. Las civilizaciones que surjan por entonces no podrán saber sobre el verdadero pasado del Universo porque carecerán de los datos observacionales.

En cierto modo pertenecemos a una época privilegiada en la que podemos saber el origen y evolución del Universo. La ventana temporal a través de la cual una civilización inteligente puede conocer la verdadera naturaleza del Universo es muy estrecha y nos ha tocado vivirla.

O quizás ya se produjo algún tipo de olvido cósmico en el pasado y la idea que tenemos del Universo es incorrecta aunque consistente con los datos que tenemos ahora, datos que quizás nunca serán suficientes para saber la verdad, o lo que sea que signifique eso.