Un equipo de científicos de la

Universidad de Illinois, en Estados Unidos, ha creado el primer estado de realidad combinada en un sistema físico. Utilizando un péndulo virtual y otro real, que fueron ajustados el uno al otro mediante un acoplamiento bidireccional instantáneo, cada uno de ellos pudo “sentir” al otro.

Los movimientos de los dos péndulos se sincronizaron entre sí, y ambos comenzaron a balancearse como si fueran uno solo, informa dicha universidad en un

comunicado.

Alfred Hubler, profesor del

Departamento de Física, declaró que en un estado de

realidad combinada no existe una frontera clara entre el sistema real y el sistema virtual. “La línea entre lo que es real y lo que no lo es se difumina”, añadió.

Sincronización del movimiento En el experimento, Hubler y el estudiante

Vadas Gintautas, conectaron el péndulo mecánico al virtual, que se movía según determinadas ecuaciones de movimiento. Los investigadores introdujeron datos sobre el péndulo real en el virtual, y enviaron información sobre el virtual a un motor que regía el movimiento del péndulo real.

En otras palabras, se introdujeron parámetros en el péndulo virtual y se produjo una retroalimentación de la información (que llegó al péndulo mecánico), consiguiendo así que los dos sistemas se movieran sincronizadamente. En este estado de realidad combinada, el péndulo real y el virtual se balancearon como si fueran uno.

Cuando las distancias de los dos péndulos eran diferentes, ambos se mantenían en un estado de realidad dual, manteniendo movimientos no sincronizados. Sin embargo, cuando la distancia era similar, ambos péndulos “de pronto, se percibían el uno al otro, sincronizando sus movimientos y danzando juntos indefinidamente”, afirmó Hubler.

Control del mundo físico Aunque anteriormente ya se habían acoplado péndulos mecánicos para generar movimientos sincronizados, ésta es la primera vez que se acopla un sistema mecánico a un sistema virtual. El estado de realidad combinada resultante ha sido posible gracias a la velocidad informática de la tecnología computacional actual.

Según Hubler, los ordenadores son ahora lo suficientemente rápidos como para detectar la posición de un péndulo real, calcular la dinámica del péndulo virtual, y computar una información de vuelta apropiada para el péndulo físico. Un proceso que se desarrolla en tiempo real.

En otro artículo publicado por los científicos en la revista especializada

Physical Review E, éstos señalan que con el rápido avance de la tecnología computacional, los sistemas virtuales se igualan a sus “dobles” reales con una precisión jamás lograda.

Estos estados de realidad combinada pueden usarse para analizar y controlar con gran exactitud sistemas reales. Además, se abre la posibilidad de explorar el hecho de que un mundo virtual pueda afectar a objetos del mundo físico.

Posibles aplicaciones El experimento de Hubler y Gintautas demuestra las posibilidades que ofrece la realidad combinada. Dado que ésta se produce sólo cuando los sistemas virtual y real son similares, se pueden utilizar sistemas virtuales para aprender más sobre cualquier sistema real, al que no podamos tener acceso directamente.

De hecho, a medida que se ajusten los parámetros del sistema virtual para lograr la realidad combinada, los científicos aseguran que se podrán desarrollar estimaciones cada vez más exactas acerca del sistema real. Estas combinaciones perfeccionadas servirían, por ejemplo, para desarrollar video juegos o simuladores de vuelo.

Pero si los mundos virtuales se convierten cada vez más en afinadas descripciones del mundo real también podría existir un peligro. Según Hubler, podría llegar el momento, en una fase de transición, en el que la frontera entre realidad y realidad virtual desaparezcan.

Y eso podría ocasionar problemas, como que no seamos capaces de determinar qué es real y que no. En ese caso, cualquier individuo que percibiera una amenaza en un mundo virtual podría sentirse amenazado en el mundo real, y volverse agresivo en éste.

Por eso, advierte el científico, necesitaríamos comprender a fondo esta fase de transición potencial antes de que los sistemas virtuales mejoren hasta tal punto que realmente puedan inducir transiciones repentinas a estados de realidad combinada.

Interrealidad La realidad combinada, a la que también se denomina

realidad aumentada, es el campo de la tecnología que estudia la manera de combinar el mundo real con los mundos virtuales para producir nuevos entornos donde los objetos físicos y digitales coexistan e interactúen en tiempo real.

Esta realidad se está desarrollando en diversos sectores, como el arte o la industria del ocio, pero también en la educación o en el mundo empresarial. Para ellos, la realidad combinada supone, por ejemplo, que existan productos interactivos (como catálogos en tres dimensiones) o fórmulas de aprendizaje también interactivas.

En un contexto físico, el experimento de Hubler y Gintautas supone que un sistema de realidad virtual se acople a un sistema correspondiente que pertenece al mundo real, produciendo un estado de inter-realidad.

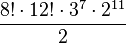

posibilidades. Con las aristas pasa lo mismo, es decir, que podemos combinarlos como queramos lo que da lugar a

posibilidades. Con las aristas pasa lo mismo, es decir, que podemos combinarlos como queramos lo que da lugar a  posibilidades, pero la permutación total de vertices y aristas debe de ser en total par lo que nos elimina la mitad de las posibilidades. Por otra parte, podemos rotar todos los vértices como queramos salvo uno sin cambiar nada más en el cubo. La orientación del último vértice vendrá determinada por la que tenga los otros siete y esto nos crea

posibilidades, pero la permutación total de vertices y aristas debe de ser en total par lo que nos elimina la mitad de las posibilidades. Por otra parte, podemos rotar todos los vértices como queramos salvo uno sin cambiar nada más en el cubo. La orientación del último vértice vendrá determinada por la que tenga los otros siete y esto nos crea  posibilidades. Con las aristas pasa lo mismo, es decir, nos aparecen

posibilidades. Con las aristas pasa lo mismo, es decir, nos aparecen  posibilidades más. En total tendremos que el número de permutaciones posibles en el Cubo de Rubik es de:

posibilidades más. En total tendremos que el número de permutaciones posibles en el Cubo de Rubik es de: = 43.252.003.274.489.856.000

= 43.252.003.274.489.856.000